详细介绍

Ollama 的主要功能

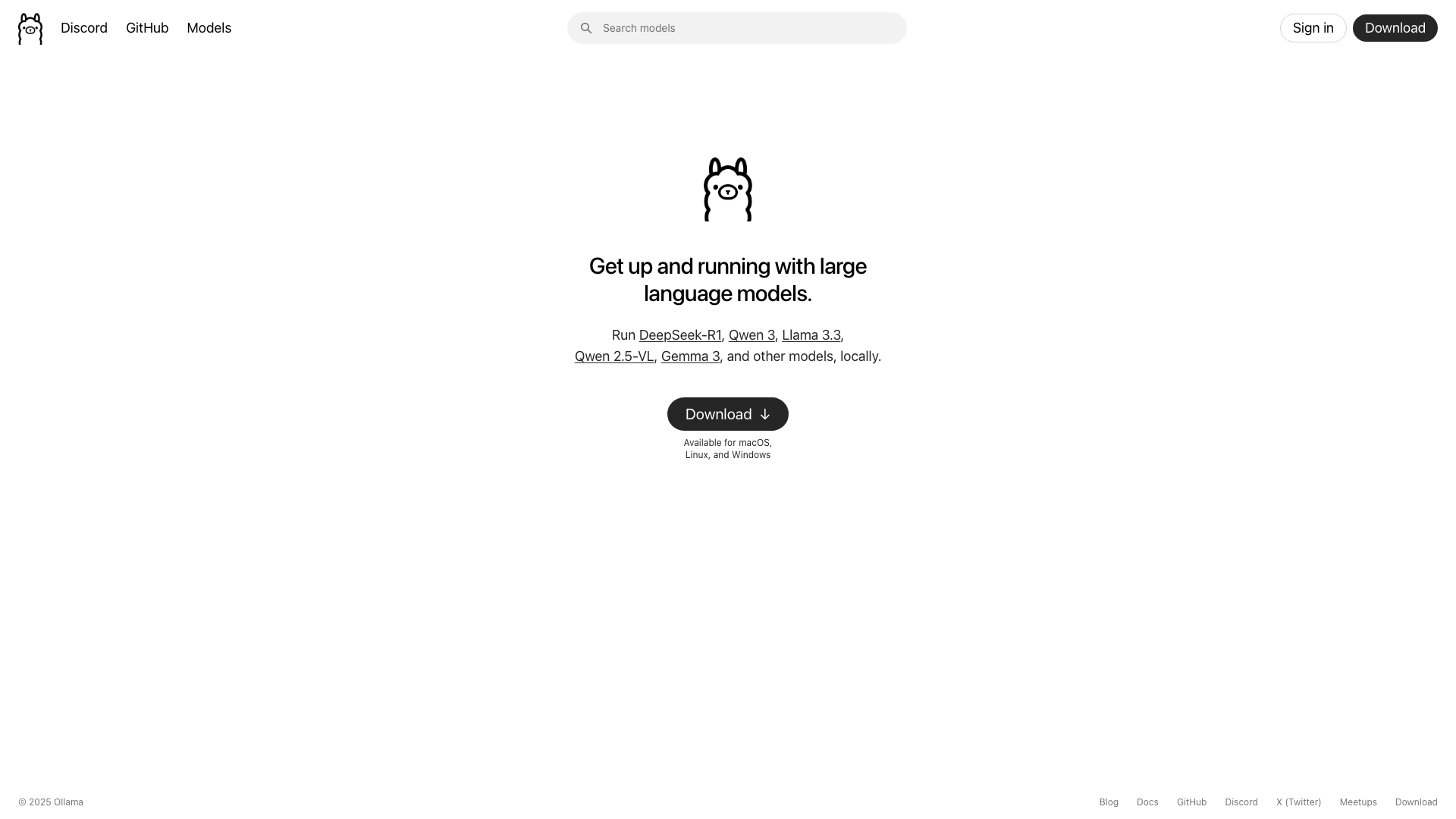

- 本地运行大型语言模型:Ollama支持在本地运行多种大型语言模型,如Llama 2、Code Llama等。用户可以通过简单的命令行工具下载和运行这些模型,无需复杂的配置或依赖云端服务。Ollama还支持模型的自定义和微调,适合开发者进行实验和研究。

- 模型管理与更新:Ollama提供了便捷的模型管理功能,用户可以轻松下载、更新和切换不同的模型版本。工具会自动处理模型的依赖关系和存储路径,确保用户始终使用最新的模型版本。此外,Ollama还支持多模型并行运行,满足不同场景的需求。

- 命令行交互:Ollama通过命令行界面(CLI)提供交互式体验,用户可以直接在终端中输入命令与模型交互。这种方式不仅高效,还适合开发者集成到其他工具或脚本中。Ollama的命令行工具支持多种参数配置,如模型选择、温度调节等,满足个性化需求。

适用角色

- 开发者:开发者可以使用Ollama在本地快速部署和测试大型语言模型,无需依赖云端服务。通过命令行工具,开发者可以轻松集成模型到自己的项目中,进行自然语言处理、代码生成等任务。Ollama的开源特性也允许开发者自定义模型,满足特定需求。

- 科研人员:科研人员可以利用Ollama在本地运行和实验大型语言模型,进行学术研究或模型优化。Ollama支持多种模型和版本,方便科研人员对比不同模型的性能。本地运行还能避免数据隐私问题,适合处理敏感数据的研究。

- 内容创作者:内容创作者可以通过Ollama在本地使用大型语言模型生成文本内容,如文章、故事或脚本。本地运行确保了内容的隐私性和快速响应,避免了云端服务的延迟。Ollama还支持模型的微调,帮助创作者生成更符合需求的个性化内容。

工具特点

- 开源与社区支持:Ollama是一个开源项目,拥有活跃的开发者社区。用户可以通过GitHub提交问题、贡献代码或分享使用经验。开源特性使得Ollama能够快速迭代,不断优化功能和性能。社区还提供了丰富的文档和教程,帮助用户快速上手。

- 跨平台支持:Ollama支持多种操作系统,包括macOS、Linux和Windows(通过WSL)。这种跨平台特性使得用户可以在不同的开发环境中使用Ollama,无需担心兼容性问题。Ollama还提供了详细的安装指南,确保用户在不同平台上都能顺利运行。

- 轻量级与高效:Ollama的设计注重轻量级和高效性,能够在资源有限的本地环境中运行大型语言模型。工具优化了模型的加载和运行过程,减少了内存和CPU的占用。用户可以通过简单的命令行工具快速启动模型,无需复杂的配置或管理。

使用场景

- 本地开发与测试:开发者可以在本地使用Ollama运行Llama 2模型,测试其自然语言处理能力。通过命令行工具,开发者可以输入提示词并获取模型的生成结果,快速验证模型的效果。这种方式避免了云端服务的延迟和费用,适合频繁的开发和测试场景。

- 学术研究与实验:科研人员可以使用Ollama在本地运行多个版本的模型,对比其性能差异。通过命令行工具,科研人员可以调整模型参数(如温度、top-p等),研究不同设置对生成结果的影响。本地运行还能确保数据的隐私性,适合处理敏感研究数据。

- 内容生成与创作:内容创作者可以通过Ollama在本地运行Code Llama模型,生成代码片段或技术文档。创作者可以输入具体的需求或问题,模型会生成相应的内容。本地运行确保了生成内容的快速响应和隐私性,适合需要高效创作的场景。

收费方案

- 免费开源:Ollama是一个完全免费的开源工具,用户可以自由下载、使用和修改。工具不提供付费版本或订阅服务,所有功能均免费开放。用户需要自行承担运行模型所需的硬件资源(如GPU、内存等)。

使用方法

- 安装Ollama:1. 访问Ollama官网(https://ollama.ai/)下载对应操作系统的安装包。 2. 按照安装指南完成安装(macOS和Linux用户可通过命令行安装,Windows用户需使用WSL)。 3. 安装完成后,在终端中输入`ollama --version`验证安装是否成功。

- 下载并运行模型:1. 在终端中输入`ollama pull llama2`下载Llama 2模型(或其他支持的模型)。 2. 下载完成后,输入`ollama run llama2`启动模型。 3. 在交互式命令行中输入提示词,模型会生成相应的回复。

- 自定义模型:1. 创建一个Modelfile文件,定义模型的自定义参数(如基础模型、温度等)。 2. 在终端中输入`ollama create my-model -f Modelfile`创建自定义模型。 3. 使用`ollama run my-model`运行自定义模型。

常见问题

Ollama支持哪些模型?

Ollama支持多种大型语言模型,包括Llama 2、Code Llama等。用户可以通过`ollama list`命令查看已安装的模型,或通过`ollama pull`命令下载新的模型。Ollama的GitHub页面会定期更新支持的模型列表。

Ollama需要什么样的硬件配置?

Ollama的运行需求取决于所选模型的大小和复杂度。一般来说,运行Llama 2等大型模型需要至少16GB内存和支持CUDA的GPU(如NVIDIA显卡)。对于较小的模型或轻量级任务,CPU也可以满足需求。用户可以根据自己的硬件条件选择合适的模型。

如何更新Ollama和模型?

Ollama可以通过`ollama update`命令更新到最新版本。模型的更新则需要通过`ollama pull`命令重新下载最新版本的模型。Ollama会自动检查更新并提示用户,确保工具和模型始终保持最新状态。

最新资讯

亚马逊云科技入局Vibe Coding,推出Kiro重塑开发流程

16

马斯克的XAI推出【智能伙伴】功能,居然支持18禁模式?

30

Google开源了一个AI命令行神器,程序员狂欢!这就是传说中的Gemini CLI

54

Cursor AI编程工具模型全面解析:2025年最新完整模型列表与深度对比

156

用Veo 3+Suno做了个AI Rapper,吊打音乐节上的流量明星

17

相似工具推荐

发现更多同类优质AI工具

魔撰写作

出门问问旗下推出的AI智能写作工具

AI小说写作AI公文写作AI专业写作

内容创作者

0

秒出PPT

一键生成PPT,智能辅助编辑

AI文档工具AI PPT生成

决策汇报者

0

135 AI排版

公众号AI图文排版和智能文案生成工具

AI文档工具AI专业写作

内容创作者

0

清言PPT

智谱清言联合AiPPT推出的PPT生成智能体

AI文档工具AI PPT生成

决策汇报者

0

文心智能体平台

百度推出的智能体构建平台

AI开发平台通用聊天机器人扮演对话

开发者

0

库宝AI工作助手

千库网推出的多功能AI创作工具

AI图像生成AI图像处理

设计师

0

千图网

在线设计图片素材平台

AI图像生成AI图片优化修复AI PPT生成

设计师

0

66AI论文

高质量、低查重、低AIGC率的AI论文写作工具

学术研究辅助AI论文写作

学生

40

通义万相AI视频

通义万相AI视频是阿里推出的...

AI视频编辑AI视频生成

内容创作者

0

百度作家平台

百度免费AI小说写作工具

AI小说写作

内容创作者

0